Fundamentos de Programación

Ramiro A. Lopera Sánchez

Título de la obra:

Fundamentos de Programación

Autor:

Ramiro A. Lopera Sánchez

Código JavaScript para el libro: Joel Espinosa Longi, IMATE, UNAM.

Imagen de portada: http://angeligarcia0305.blogspot.com.co

Recursos interactivos: DescartesJS

Fuentes: Lato y UbuntuMono

Fórmulas matemáticas: $\KaTeX$

Red Educativa Digital Descartes

Córdoba (España)

descartes@proyectodescartes.org

https://proyectodescartes.org

Proyecto iCartesiLibri

https://proyectodescartes.org/iCartesiLibri/index.htm

https://prometeo.matem.unam.mx/recursos/VariosNiveles/iCartesiLibri/

Esta obra está bajo una licencia Creative Commons 4.0 internacional: Reconocimiento-No Comercial-Compartir Igual. Todos los objetos interactivos y los contenidos de esta obra colectiva están protegidos por la Ley de Propiedad Intelectual.

En este libro tendrá la oportunidad de conocer sobre los algoritmos y las diferentes estructuras básicas de diagramación, el manejo de los operadores lógicos y matemáticos, las reglas de prioridad, los diferentes tipos de datos, las entradas y salidas; también podrá identificar conceptos de las áreas de almacenamiento de datos como la diferencia entre variables y constantes, manejo de estructuras de decisión de selección doble, anidada y múltiple aplicado a las diferentes requerimientos del problema.

Dando inicio al tema de los algoritmos, tipos, clases y lenguajes algorítmicos abordaremos dos conceptos que son de gran importancia: lógica y algoritmo, en la siguiente tabla encuentra la definición de cada concepto con su respectivo ejemplo.

| Lógica | Algoritmo |

|---|---|

| Procedimiento razonable y apropiado para buscar la solución de un problema cualquiera. | Serie de pasos organizados que describe el proceso que se debe seguir, para dar solución a un problema específico. ¿Qué se pide? ¿Qué se tiene?. La respuesta a estas preguntas son la base para plantear una posible solución y si ésta se da por medio del computador, nuestro primer paso será realizar un Algoritmo o sea la descripción de esa posible solución con palabras. Este debe cubrir la solución del problema desde su inicio hasta su terminación. |

|

Ejemplo:

|

Ejemplo:

Programa “ |

Cuando haces clic en el ratón o en el teclado, se envía un mensaje a la computadora reportando su ubicación o comandos de texto indicando acciones a realizar para procesar los datos y generar resultados lógicos de acuerdo a tus peticiones.

Para poder entender los tipos de datos y su utilización en la lógica de programación y los distintos lenguajes, vamos primero a conocer y entender los fundamentos principales de la informática: A diario nos vemos en la necesidad de utilizar datos, recibir, procesar e intercambiar información, pero no estamos conscientes de toda la lógica que ello implica; lo que nos lleva a una pregunta importante, ¿que se define como lógica en la informática?

Algunos ingenieros la definen como una serie coherente de ideas y razonamientos; es “la forma más obvia y más fácil de hacer algo”.

Un bit es la unidad elemental de información que utilizan las computadoras y que sólo puede tener dos posibles valores 0 o 1; encendido o apagado; verdadero o falso; abierto o cerrado, un conjunto de8 bits forman 1byte por regla general, aunque las computadoras antiguas podían usar bytes de 6, 7, 8 o 9 bits.

En el primer espacio escribe una cadena con 1 o 0 en una cantidad de 8 dígitos para verificar a cuál carácter corresponde.

En el segundo espacio escribe un texto para convertirlo en código binario.

El sistema numérico binario fue el escogido por los ingenieros informáticos para el funcionamiento de los ordenadores, porque era más fácil para el sistema electrónico de la máquina distinguir y manejar solamente dos dígitos, o sea, el “0” y el “1” que componen el sistema numérico binario, en lugar de los diez dígitos (del 0 al 9), que constituyen el sistema numérico decimal.

Todos los programas, instrucciones, textos y órdenes que introducimos en el ordenador éste las recibe en código binario como una cadena de ceros y unos. Cada cero (“0”) y cada uno (“1”), representa un “bit” de información. La palabra “bit” constituye el acrónimo de Binary DigIT, que significa “dígito binario”.

Para formar cada carácter alfanumérico, es decir una letra, número o signo, los ingenieros informáticos, después de realizar muchas pruebas, optaron por combinar ocho bits o cadena de ceros y unos para formar un “octeto” al que denominaron “byte”.

A cada carácter alfanumérico le asignaron un byte de información y estructuraron 256 valores binarios distintos en un código que llamaron ASCII (American Standard Code for Information Interchange – Código Estándar Americano para Intercambio de Información)

En el Código ASCII los valores binarios entre 0 y 31 corresponden a instrucciones, entre 32 y 127 corresponden al alfabeto alfanumérico y entre 128 y 255 a caracteres de otros idiomas y signos menos convencionales.

En el mundo de las matemáticas el sistema decimal no es único que existe para realizar cálculos simples o complejos. Coexisten, además, otros sistemas numéricos, prácticamente desconocidos para la mayoría de la gente, entre los que se encuentran el “sistema numérico hexadecimal”, de “base 16”, y el “sistema numérico binario”, de “base 2”.

Este último es el más utilizado en informática y emplea para efectuar todas las operaciones matemáticas solamente el “0” y “1”, dígitos con los cuales los ordenadores realizan todas las operaciones para las que fueron concebidos. De ahí su denominación de “dispositivos digitales”.

A continuación encuentra el clásico juego de Tic Tac Toe o también conocido como 3 en línea, donde mediante una combinación de variables y vectores puedes interactuar con la máquina; más adelante te explicamos como funcionan.

Cuando nos referimos a un objeto o persona, usualmente hacemos comentarios respecto a su imagen o apariencia a primera vista, que es alto, bajo, gordo, flaco, hombre, mujer, entre otros, esto lo llamamos “ATRIBUTO”, siendo este una característica identificativa de un ente informático.

Y ¿qué es un ente informático? Es todo aquello que podemos describir a través de características.

El atributo tiene dos particularidades:

Si en tu ciudad una persona que mide 1.70 cm se considera alta, y luego se traslada a occidente puede no ser una persona realmente alta, si vive en Europa será a una persona baja y si vive en Oriente será a una persona realmente alta. Los atributos siempre van a estar sujetos a la relatividad del prisma con que la observe quien vaya a dar concepto. Igual es el caso de atributos como la belleza, depende mucho del observador que los esté manejando.

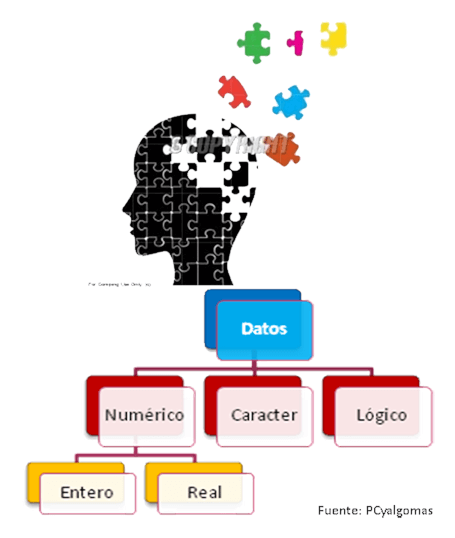

Los atributos deben ser tasados a través de una escala ya que esto los hace manejables y no relativos, esto genera un Dato: Un atributo “codificado” en términos entendibles a un sistema de información, en condiciones manejables y comparables y de manera casi absoluta. Que un atributo sea “codificado” significa que ha sido convertido a una escala x para poder ser más manejable lo cual indica que lo podemos operar con otros atributos de la misma escala, es decir, podemos realizar comparaciones y obtener resultados y respuestas, tal como lo explica la siguiente animación.

Tenemos identificada información clave sobre Diana: su nombre, su género y su estatura, representados en Campos. En un conjunto de campos en donde cada campo tiene consignado un dato y todos los datos pertenecen o describen a un mismo ente informático, se genera un Registro que en este caso podemos llamar Persona.

Si generamos varios campos, formando un conjunto de registros que tienen la misma estructura y puede ser manejado como una sola unidad, almacenamos la información en un Archivo.

Variable es un campo de memoria al que se le puede cambiar el contenido cuantas veces sea necesario. Un campo de memoria es un pedacito de la memoria principal del ordenador donde podemos guardar un dato.

La información se almacena en variables, esto nos indica que es a través de variables como se puede utilizar la memoria del computador. Estas son como unas cajitas de diferentes tamaños y por ello se deben declaran previamente para que el ordenador las dimensione de acuerdo a las necesidades.

Todo este conjunto de definiciones nos ha llevado desde un concepto muy humano como es el Atributo hasta un concepto muy técnico como es la Base de datos. Pero si miramos el trasfondo de toda esta secuencia podemos descubrir cuál es su objetivo fundamental. El objetivo es poder hablar de información, si, y ¿Cómo se puede definir la información? Pues la información no es más que un conjunto de datos suficientemente organizados y entendibles (algunas veces organizados utilizando tecnología pero no necesariamente).

Esto nos permite abordar debidamente el término informática.

No es más que la ciencia que estudia, aplica y optimiza el tratamiento eficiente de la información.

¿Por qué al hablar de Informática se relaciona el concepto con computadores? En la actualidad los computadores son los dispositivos que mejor pueden cumplir con el objetivo de la Oportunidad ya que trabajan a velocidades altas (millonésimas de segundo). Y quién se encargada de cumplir con la veracidad? Pues el ser humano quien planea, organiza, programa y ejecuta todo lo que el computador va a entregar como información.

¿Sabe usted que significa el tratamiento eficiente de la información?

Sencillamente que es la ciencia que se ocupa de que la información, cualquiera que sea su procedencia o su destinación, cumpla con dos objetivos:

Cuando se trate de algoritmos computacionales deberán ir orientados a facilitar la codificación posterior precisamente para tener toda la certeza de que el computador va a ejecutar lo que nosotros hemos concebido como solución.

Trate de utilizar en sus algoritmos, ordenes que sean de fácil conversión a cualquier lenguaje de programación convencional. No olvide que lo más importante en el desarrollo de soluciones computacionales es la lógica que se haya utilizado para solucionar un determinado problema. Siempre tenga en cuenta que de una buena lógica utilizada en la construcción de los algoritmos dependen los buenos programas, es decir, las buenas aplicaciones.

“There is a mind-boggling amount of data floating around our society”.

“Hay una increíble cantidad de información flotando alrededor de nuestra sociedad”.

Los físicos del CERN han estado reflexionando sobre la forma de almacenar y compartir sus datos cada vez más masivos durante décadas - la estimulación de la globalización de la Internet en el camino, mientras que “la solución” de su problema de grandes datos.

Tim Smith traza la participación del CERN con grandes datos desde hace cincuenta años hasta la actualidad.

Observaremos el siguiente video que presenta en detalle el concepto del Big Data y su importancia en los procesos informáticos y de gestión de la información.

Realiza la siguiente actividad para validar los conocimientos adquiridos en este libro.